소개

Portkey는 CrewAI에 프로덕션 적합성을 위한 기능을 추가하여 실험적인 agent crew를 다음과 같이 견고한 시스템으로 전환합니다.- 모든 agent 단계, 도구 사용, 상호작용에 대한 완전한 관찰 가능성

- 내장된 신뢰성: 폴백, 재시도, 로드 밸런싱 기능 제공

- AI 비용 관리를 위한 비용 추적 및 최적화

- 단일 통합을 통한 200개 이상의 LLM 접근

- agent의 행동을 안전하고 규정 준수로 유지하는 가드레일

- 일관된 agent 성능을 위한 버전 관리되는 prompt

설치 및 설정

API 키 생성

Portkey 대시보드에서 예산/속도 제한을 선택적으로 설정하여 Portkey API 키를 생성하세요. 이 키에는 신뢰성, 캐싱 등 여러 가지 구성을 추가로 적용할 수 있습니다. 자세한 내용은 추후 설명합니다.

Portkey로 CrewAI 구성하기

통합은 매우 간단합니다. CrewAI 설정의 LLM 구성을 다음과 같이 업데이트하기만 하면 됩니다:

Virtual Key란? Portkey의 Virtual Key는 LLM 제공업체의 API 키(OpenAI, Anthropic 등)를 암호화된 금고에 안전하게 저장합니다. 이를 통해 키 교체 및 예산 관리를 더 쉽게 할 수 있습니다. Virtual Key에 대해 자세히 알아보기.

프로덕션 기능

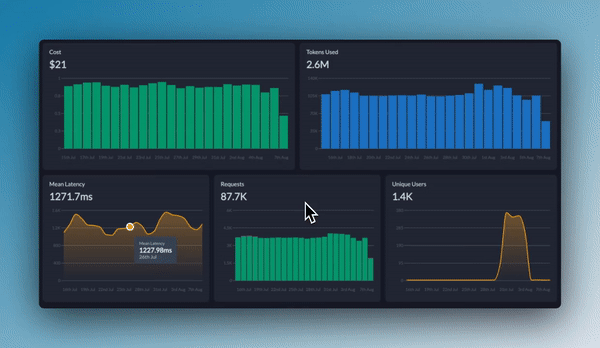

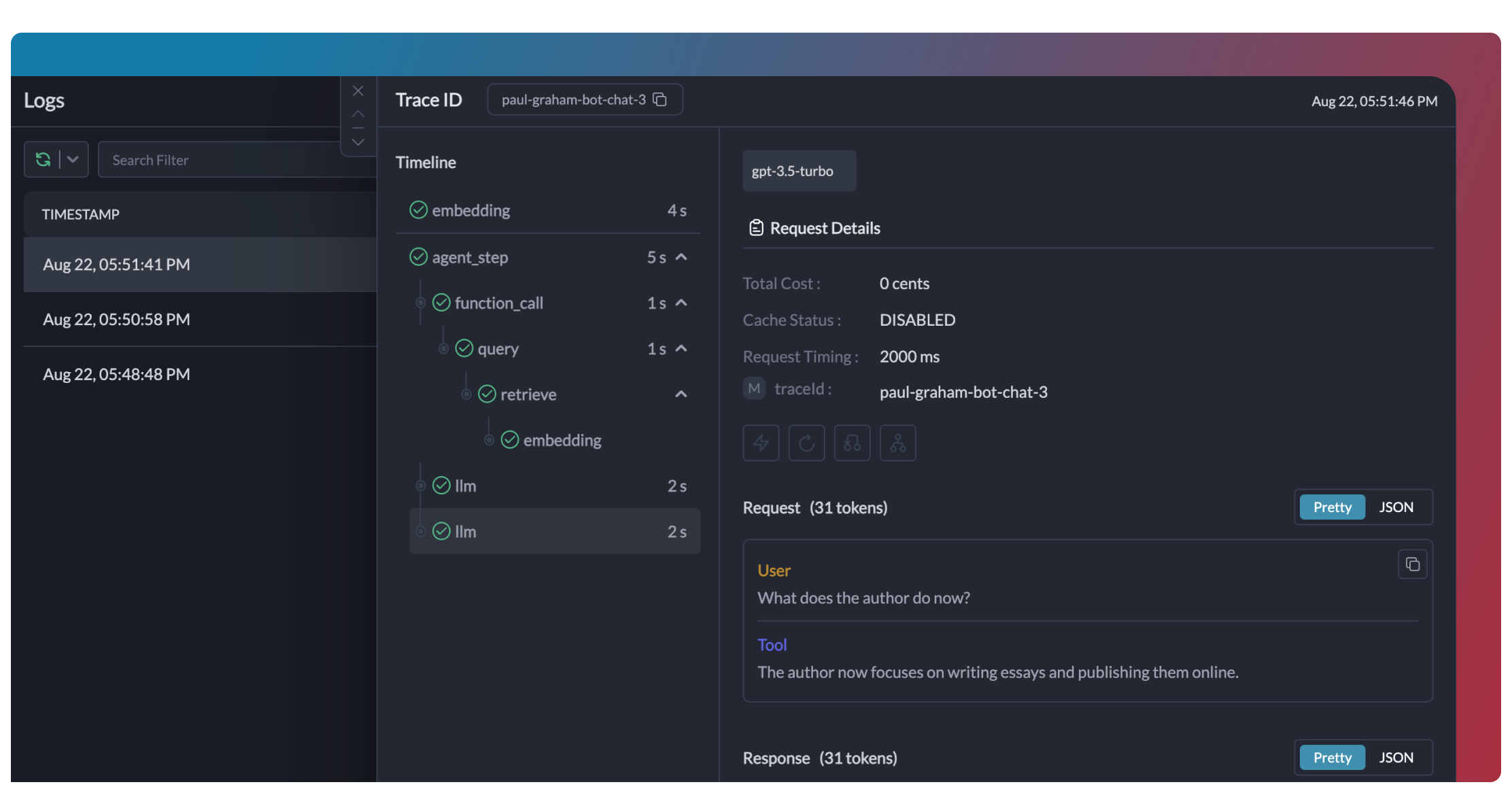

1. 향상된 가시성

Portkey는 CrewAI agent에 대한 종합적인 가시성을 제공하여 각 실행 중에 어떤 일이 일어나고 있는지 정확히 이해할 수 있게 도와줍니다.- Traces

- Logs

- Metrics & Dashboards

- Metadata Filtering

2. 신뢰성 - Crew를 원활하게 운영하세요

프로덕션에서 crew를 운영할 때, API 속도 제한, 네트워크 이슈 또는 공급자 장애와 같이 문제가 발생할 수 있습니다. Portkey의 신뢰성 기능은 문제가 발생해도 에이전트가 원활하게 동작하도록 보장합니다. Portkey Config를 사용하여 CrewAI 설정에서 페일오버를 간단하게 활성화할 수 있습니다:자동 재시도

일시적인 실패를 자동으로 처리합니다. LLM 호출에 실패하면 Portkey가 지정된 횟수만큼 동일한 요청을 재시도합니다. 속도 제한이나 네트워크 장애에서 완벽하게 사용할 수 있습니다.

요청 타임아웃

에이전트가 멈추는 것을 방지합니다. 타임아웃을 설정하여 요구되는 시간 내에 응답을 받거나(혹은 우아하게 실패할 수 있도록) 합니다.

조건부 라우팅

다양한 요청을 다양한 공급자에게 보낼 수 있습니다. 복잡한 reasoning은 GPT-4로, 창의적인 작업은 Claude로, 빠른 응답은 Gemini로 필요에 따라 라우팅하세요.

페일오버

기본 공급자가 실패해도 계속 운영됩니다. 백업 공급자로 자동으로 전환되어 가용성을 유지합니다.

로드 밸런싱

여러 API 키 또는 공급자에 요청을 분산시킵니다. 대량 crew 운영 및 속도 제한 내에서 작업할 때 유용합니다.

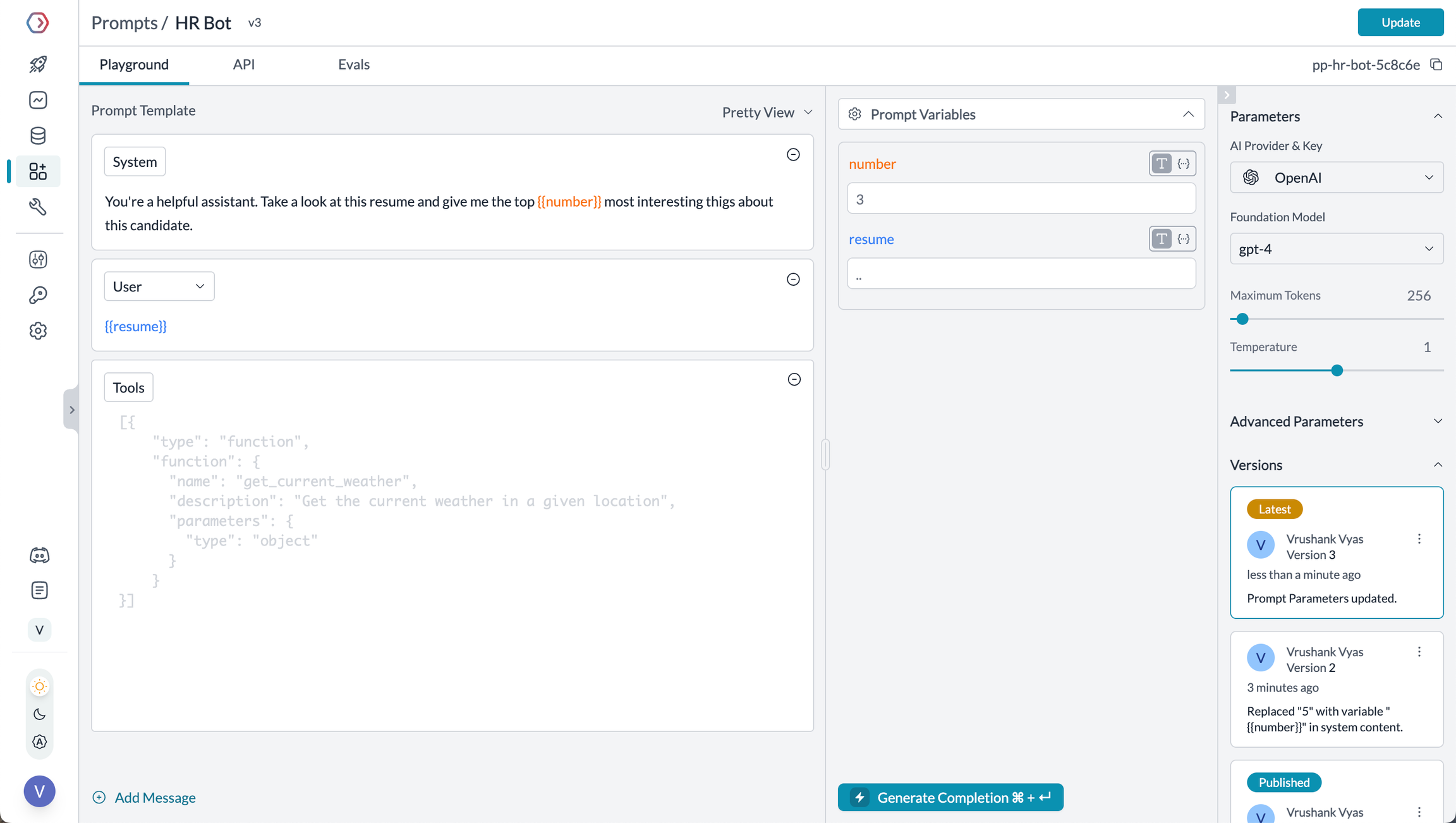

3. CrewAI에서의 프롬프트 사용

Portkey의 Prompt Engineering Studio는 CrewAI 에이전트에서 사용하는 프롬프트를 생성, 관리, 최적화하도록 도와줍니다. 프롬프트나 지시문을 하드코딩하는 대신 Portkey의 프롬프트 렌더링 API를 사용하여 버전 관리된 프롬프트를 동적으로 가져와 적용할 수 있습니다.

- Prompt Playground

- 프롬프트 템플릿 사용하기

- 프롬프트 버전 관리

- 변수용 머스태시 템플릿

Prompt Playground는 여러분의 AI 애플리케이션을 위해 완벽한 프롬프트를 비교, 테스트, 배포할 수 있는 공간입니다. 이곳은 다양한 모델을 실험하고, 변수들을 테스트하며, 출력값을 비교하고, 배포 전에 프롬프트 엔지니어링 전략을 다듬을 수 있는 곳입니다. 이를 통해 다음과 같은 작업이 가능합니다:

- 에이전트에서 사용하기 전에 프롬프트를 반복적으로 개발

- 다양한 변수와 모델로 프롬프트 테스트

- 서로 다른 프롬프트 버전의 출력값 비교

- 팀원들과 프롬프트 개발 협업

Prompt Engineering Studio

Portkey의 프롬프트 관리 기능에 대해 더 알아보기

4. 안전한 Crew를 위한 가드레일

가드레일은 CrewAI agent가 모든 상황에서 안전하게 작동하고 적절하게 응답하도록 보장합니다. 가드레일을 사용하는 이유는 무엇인가요? CrewAI agent는 다양한 실패 모드를 경험할 수 있습니다:- 유해하거나 부적절한 콘텐츠 생성

- PII와 같은 민감 정보 유출

- 잘못된 정보의 환각

- 잘못된 형식의 출력 생성

- 입력 및 출력의 PII 감지 및 마스킹

- 유해하거나 부적절한 콘텐츠 필터링

- 응답 형식을 스키마에 따라 검증

- 근거 자료와 비교하여 환각 여부 확인

- 맞춤형 비즈니스 로직 및 규칙 적용

가드레일에 대해 더 알아보기

Portkey의 가드레일 기능을 탐색하여 agent의 안전성을 높여보세요

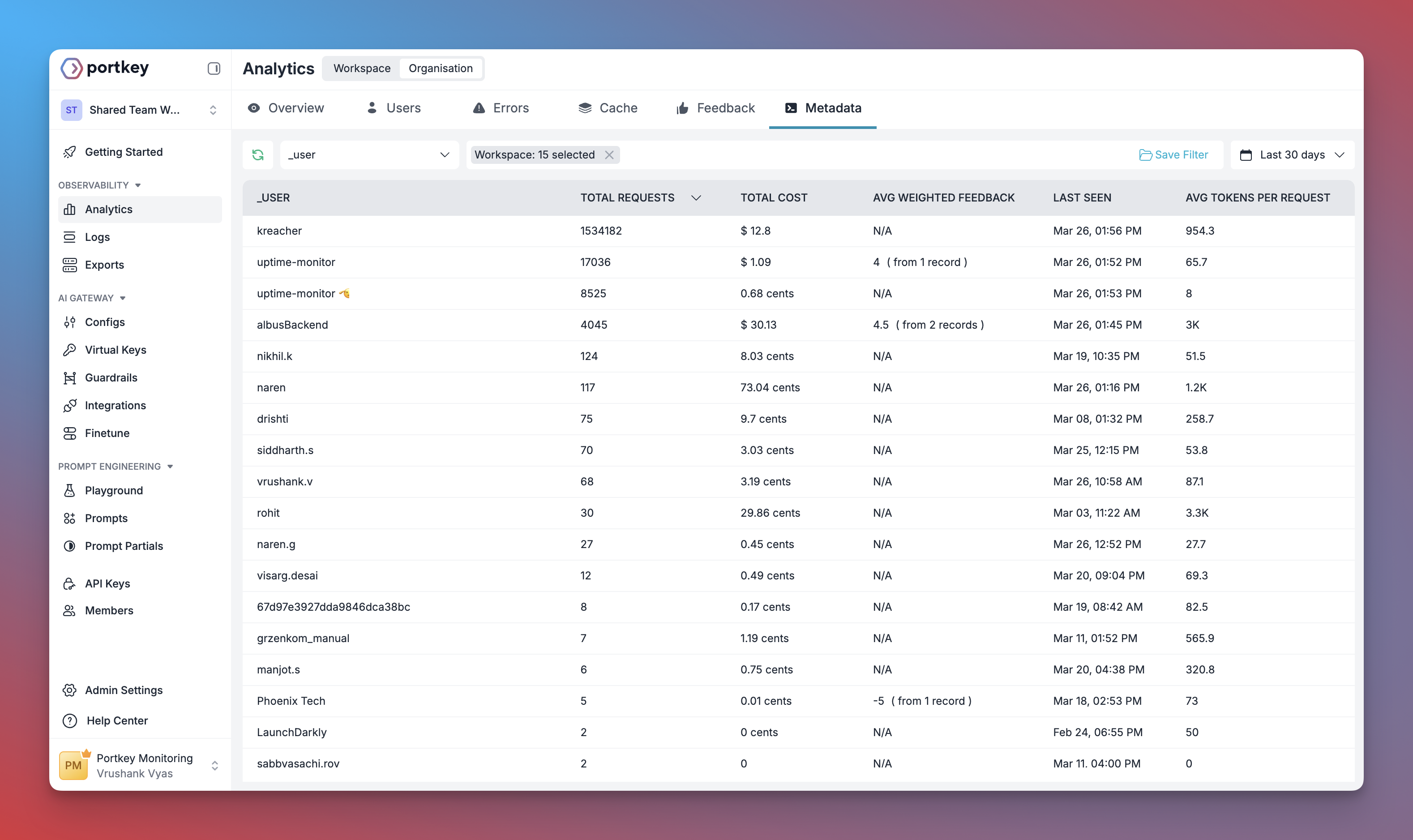

5. 메타데이터로 사용자 추적

Portkey의 메타데이터 시스템을 사용하여 CrewAI 에이전트를 통해 개별 사용자를 추적할 수 있습니다. Portkey에서의 메타데이터란? 메타데이터를 사용하면 각 요청에 사용자 지정 데이터를 연결할 수 있어 필터링, 세분화, 분석이 가능합니다. 특별한_user 필드는 사용자 추적을 위해 특별히 설계되었습니다.

- 사용자별 비용 추적 및 예산 관리

- 개인화된 사용자 분석

- 팀 또는 조직 단위의 지표

- 환경별 모니터링(스테이징 vs. 프로덕션)

메타데이터에 대해 더 알아보기

맞춤형 메타데이터를 활용하여 분석 기능을 향상시키는 방법을 살펴보세요

6. 효율적인 Crews를 위한 캐싱

캐싱을 구현하여 CrewAI agent를 보다 효율적이고 비용 효율적으로 만드세요:- Simple Caching

- Semantic Caching

7. 모델 상호 운용성

CrewAI는 여러 LLM 제공업체를 지원하며, Portkey는 통합 인터페이스를 통해 200개 이상의 LLM에 대한 액세스를 제공함으로써 이 기능을 확장합니다. 코어 에이전트 로직을 변경하지 않고도 다양한 모델 간에 쉽게 전환할 수 있습니다:- OpenAI (GPT-4o, GPT-4 Turbo 등)

- Anthropic (Claude 3.5 Sonnet, Claude 3 Opus 등)

- Mistral AI (Mistral Large, Mistral Medium 등)

- Google Vertex AI (Gemini 1.5 Pro 등)

- Cohere (Command, Command-R 등)

- AWS Bedrock (Claude, Titan 등)

- 로컬/프라이빗 모델

지원되는 제공업체

Portkey에서 지원하는 전체 LLM 제공업체 목록 보기

CrewAI를 위한 엔터프라이즈 거버넌스 설정

엔터프라이즈 거버넌스가 필요한 이유 조직 내에서 CrewAI를 사용하는 경우, 여러 거버넌스 측면을 고려해야 합니다:- 비용 관리: 팀별 AI 사용 비용 통제 및 추적

- 접근 제어: 특정 팀이 특정 모델을 사용할 수 있도록 관리

- 사용 분석: 조직 전반에서 AI 사용 현황 파악

- 보안 및 컴플라이언스: 엔터프라이즈 수준의 보안 기준 유지

- 신뢰성: 모든 사용자에게 일관된 서비스 제공 보장

Virtual Key 생성

Virtual Key는 Portkey의 안전한 LLM 공급자 API 키 관리 방식입니다. 주요 제어 기능을 제공합니다:

- API 사용에 대한 예산 제한

- 속도 제한(Rate limiting) 기능

- 안전한 API 키 저장

Virtual Key ID를 저장하세요. 다음 단계에서 필요합니다.

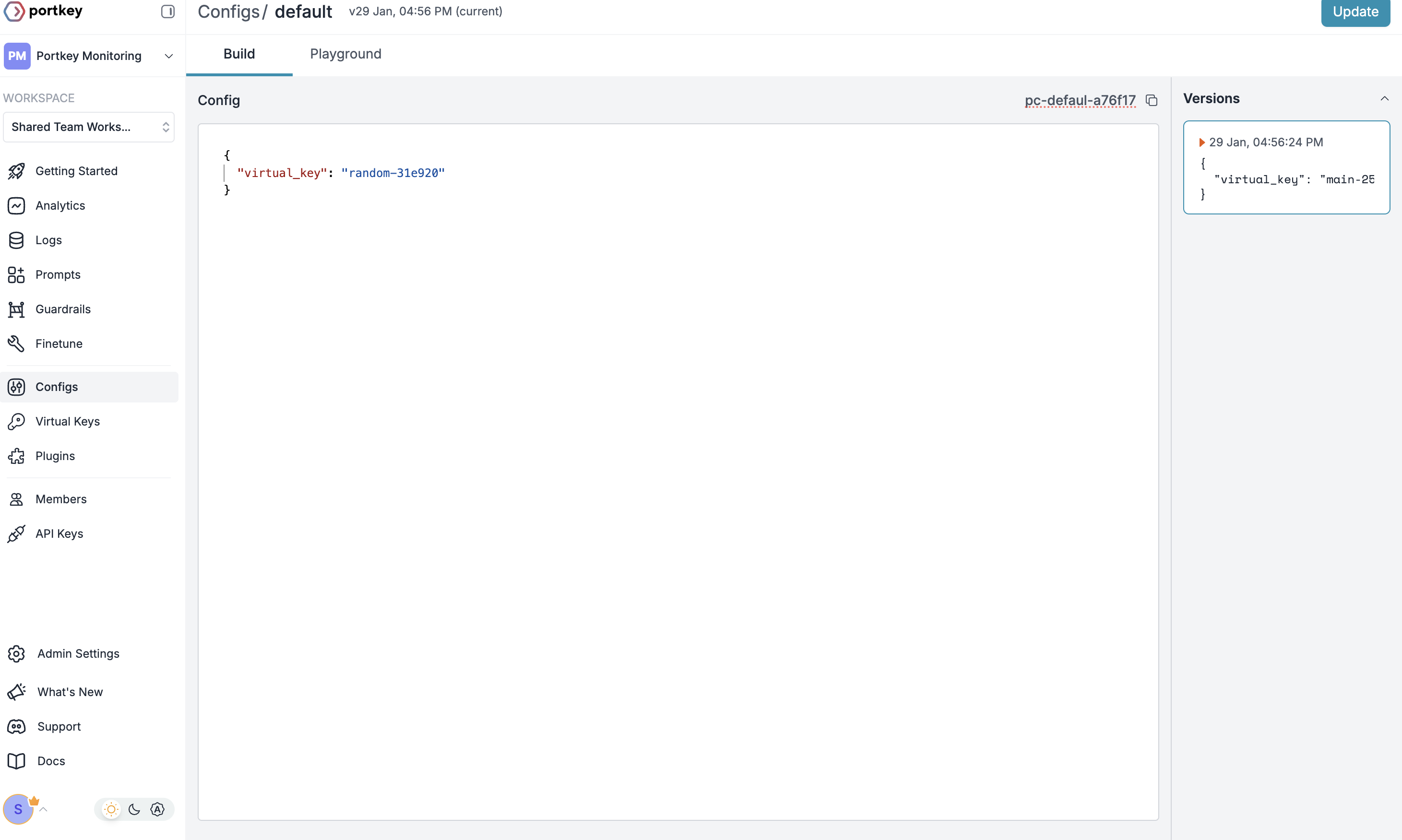

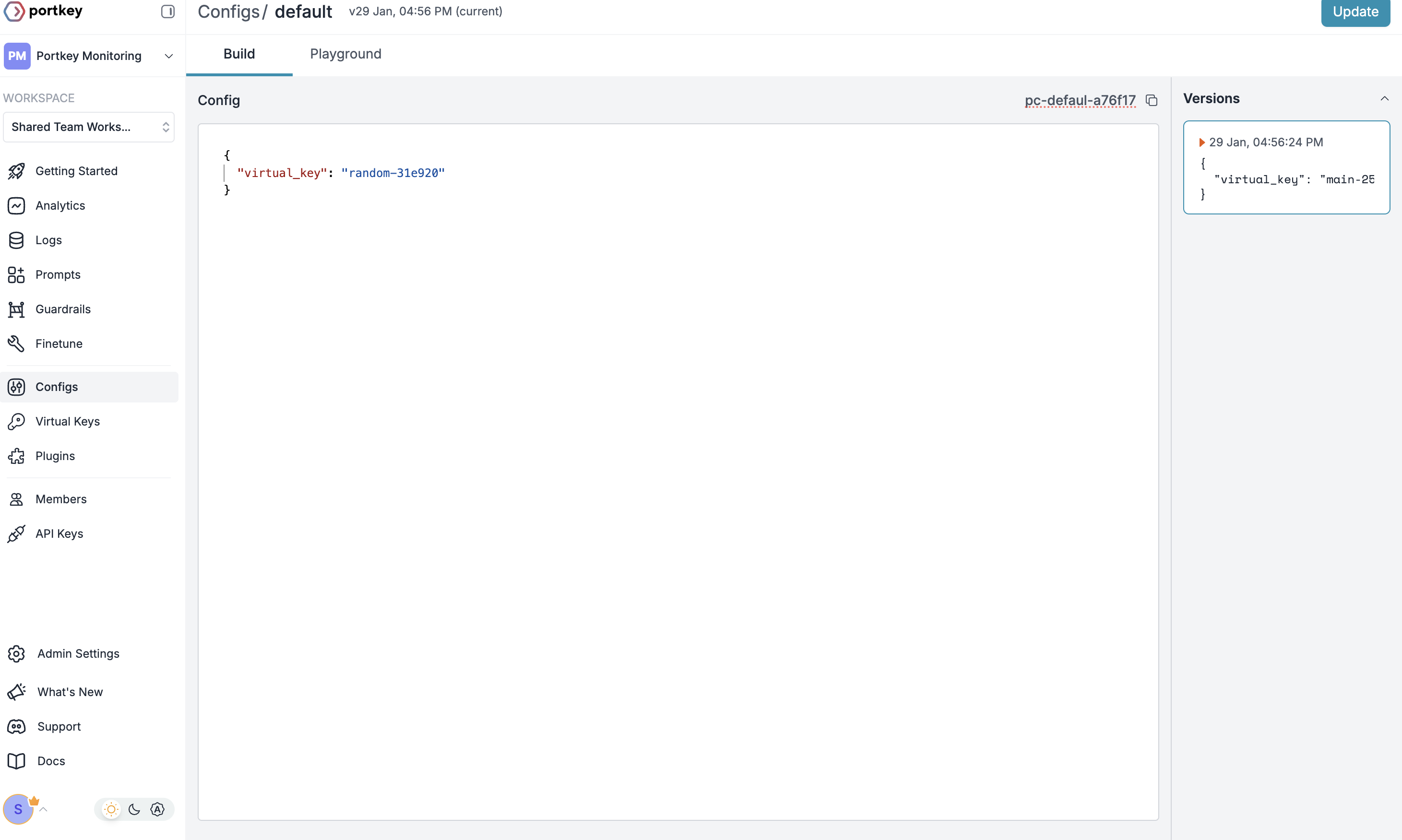

기본 Config 생성

Portkey에서 Config는 요청 라우팅 방식을 정의하며, 고급 라우팅·폴백·재시도 등 기능을 제공합니다.Config를 생성하려면:

- Portkey 대시보드의 Configs로 이동

- 아래와 같은 새 config 생성:

- Config 이름을 저장하고 다음 단계에 사용하세요.

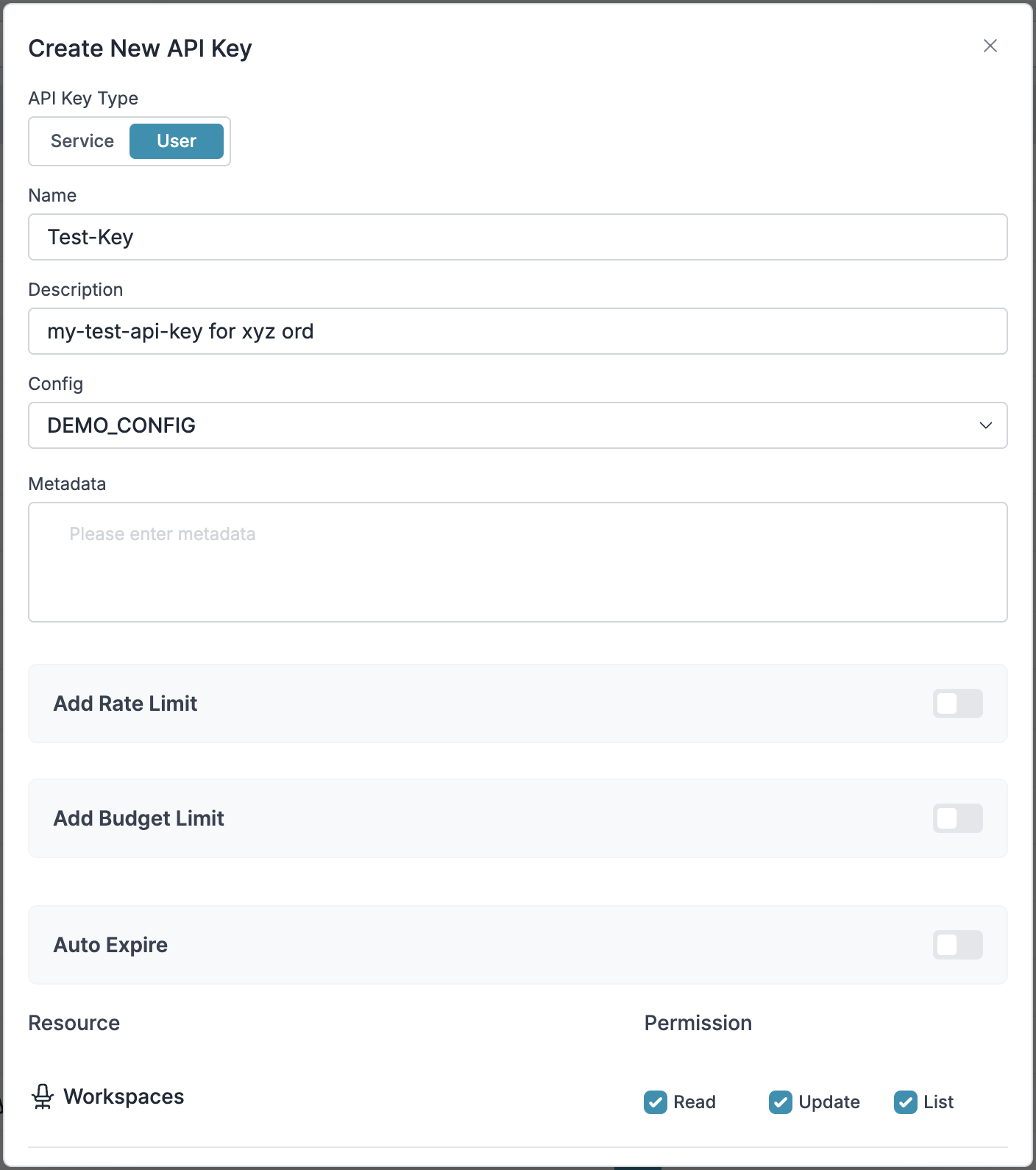

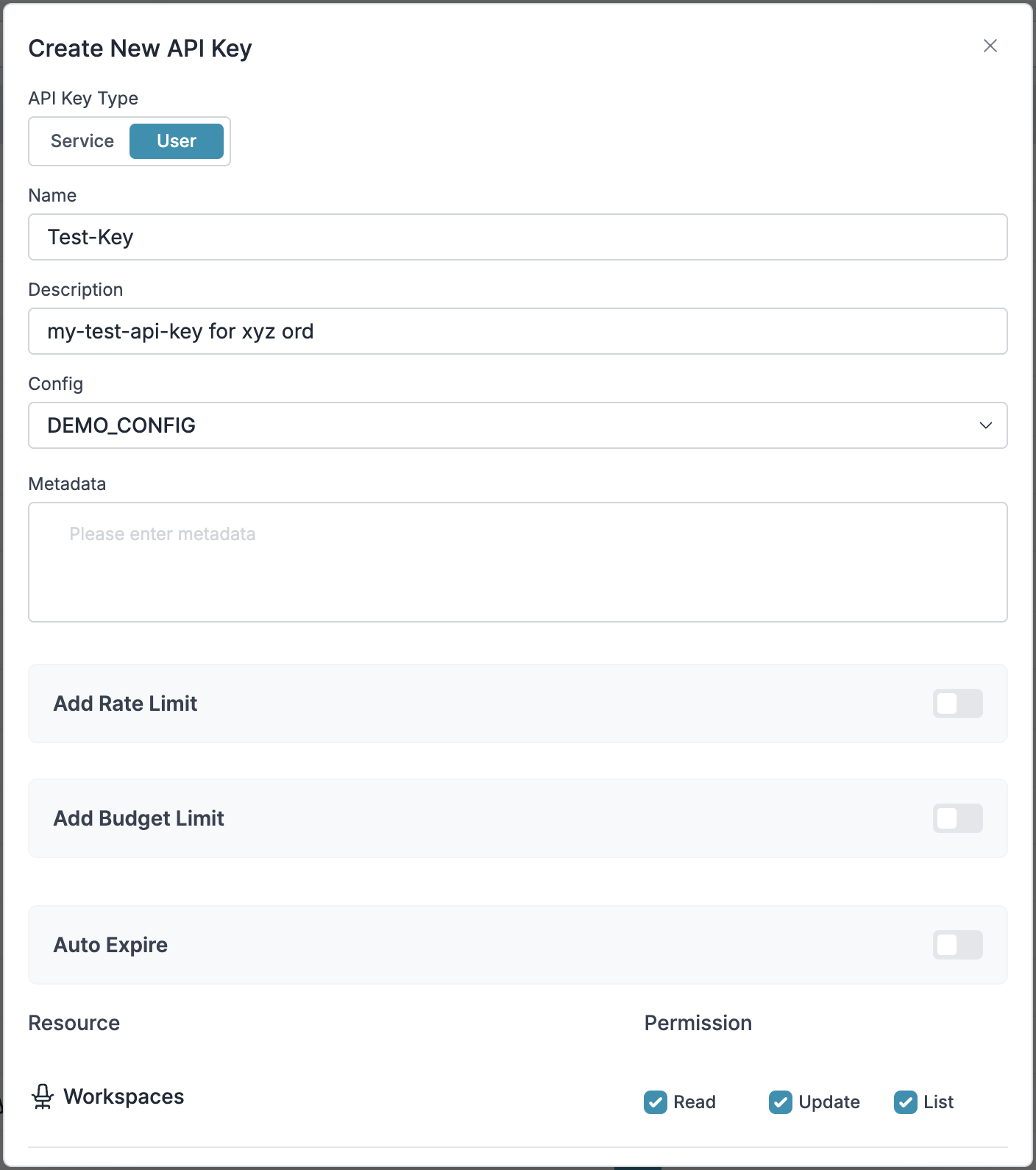

Portkey API Key 설정

이제 Portkey API 키를 생성하고, 2단계에서 만든 config에 연결하세요:

- Portkey의 API Keys로 이동해 새 API 키 생성

2단계에서 만든 config 선택- API 키를 생성 및 저장

1단계: 예산 제어 및 속도 제한 구현

1단계: 예산 제어 및 속도 제한 구현

1단계: 예산 통제 및 속도 제한 구현

Virtual Keys를 사용하면 팀/부서 수준에서 LLM 접근을 세밀하게 제어할 수 있습니다. 이를 통해 다음과 같은 이점이 있습니다:- 예산 한도 설정

- 속도 제한을 통해 예기치 않은 사용량 급증 방지

- 부서별 지출 추적

부서별 제어 설정하기:

- Portkey 대시보드에서 Virtual Keys로 이동하세요.

- 각 부서마다 예산 한도와 속도 제한이 포함된 새로운 Virtual Key를 생성하세요.

- 부서별 한도를 구성하세요.

2단계: 모델 접근 규칙 정의

2단계: 모델 접근 규칙 정의

단계 2: 모델 접근 규칙 정의

AI 사용이 확장됨에 따라, 각 팀이 특정 모델에 접근할 수 있도록 제어하는 것이 중요해집니다. Portkey Configs는 다음과 같은 기능을 제공하여 이러한 제어 계층을 지원합니다:접근 제어 기능:

- 모델 제한: 특정 모델에 대한 액세스 제한

- 데이터 보호: 민감한 데이터에 대한 가드레일 구현

- 신뢰성 제어: 폴백 및 재시도 로직 추가

예시 구성:

다음은 OpenAI, 특히 GPT-4o로 요청을 라우팅하는 기본 구성입니다:구성은 언제든지 업데이트하여 실행 중인 애플리케이션에 영향을 주지 않고 제어를 조정할 수 있습니다.

3단계: 액세스 제어 구현

3단계: 액세스 제어 구현

3단계: 액세스 제어 구현

사용자별 API 키를 생성하면 자동으로 다음을 수행합니다:- 가상 키를 활용하여 사용자/팀별 사용량 추적

- 요청 라우팅을 위한 적절한 구성 적용

- 로그를 필터링하기 위한 관련 메타데이터 수집

- 액세스 권한 적용

4단계: 배포 및 모니터링

4단계: 배포 및 모니터링

4단계: 배포 및 모니터링

팀원들에게 API 키를 배포한 후, 엔터프라이즈 준비가 완료된 CrewAI 설정이 준비됩니다. 이제 각 팀원은 지정된 API 키로 적절한 액세스 수준 및 예산 제어와 함께 사용할 수 있습니다.Portkey 대시보드에서 사용량 모니터링:- 부서별 비용 추적

- 모델 사용 패턴

- 요청량

- 오류율

엔터프라이즈 기능이 이제 사용 가능합니다

귀하의 CrewAI 통합에는 이제 다음과 같은 기능이 포함됩니다:- 부서별 예산 관리

- 모델 접근 거버넌스

- 사용량 추적 및 귀속

- 보안 가드레일

- 신뢰성 기능

자주 묻는 질문

Portkey는 CrewAI를 어떻게 향상시키나요?

Portkey는 CrewAI를 어떻게 향상시키나요?

Portkey는 종합적인 가시성(트레이스, 로그, 메트릭), 신뢰성 기능(폴백, 재시도, 캐싱) 및 통합 인터페이스를 통한 200개 이상의 LLM 접속을 통해 CrewAI에 프로덕션 환경에 적합한 기능을 추가합니다. 이를 통해 에이전트 애플리케이션을 더 쉽게 디버깅, 최적화, 확장할 수 있습니다.

Portkey를 기존 CrewAI 애플리케이션과 함께 사용할 수 있나요?

Portkey를 기존 CrewAI 애플리케이션과 함께 사용할 수 있나요?

네! Portkey는 기존 CrewAI 애플리케이션과 매끄럽게 통합됩니다. LLM 구성 코드를 Portkey가 적용된 버전으로 업데이트하기만 하면 됩니다. 나머지 에이전트 및 crew 코드는 변경하지 않아도 됩니다.

Portkey는 모든 CrewAI 기능과 호환되나요?

Portkey는 모든 CrewAI 기능과 호환되나요?

Portkey는 에이전트, 도구, human-in-the-loop 워크플로우, 모든 태스크 프로세스 유형(순차적, 계층적 등)을 포함하여 모든 CrewAI 기능을 지원합니다. 프레임워크의 기능에 제한을 두지 않으면서 가시성과 신뢰성을 추가합니다.

Crew 내 여러 에이전트의 사용 내역을 추적할 수 있나요?

Crew 내 여러 에이전트의 사용 내역을 추적할 수 있나요?

네, Portkey를 사용하면 crew 내 여러 에이전트에 일관된

trace_id를 적용하여 전체 워크플로우를 추적할 수 있습니다. 특히 여러 에이전트가 포함된 복잡한 crew에서 전체 실행 경로를 파악할 때 유용합니다.특정 crew 실행에 대한 로그와 트레이스를 어떻게 필터링하나요?

특정 crew 실행에 대한 로그와 트레이스를 어떻게 필터링하나요?

Portkey를 통해 LLM 구성에 사용자 지정 메타데이터를 추가할 수 있으며, 이를 필터링에 활용할 수 있습니다.

crew_name, crew_type, session_id와 같은 필드를 추가해 손쉽게 특정 crew 실행을 찾아 분석할 수 있습니다.내 API 키를 Portkey에서 사용할 수 있나요?

내 API 키를 Portkey에서 사용할 수 있나요?

네! Portkey는 다양한 LLM 제공업체에 대해 사용자의 API 키를 사용합니다. API 키를 가상 키로 안전하게 저장하여, 코드 변경 없이 쉽게 키를 관리하고 교체할 수 있습니다.