Integre o Langfuse ao CrewAI

Este notebook demonstra como integrar o Langfuse ao CrewAI usando OpenTelemetry via o SDK OpenLit. Ao final deste notebook, você será capaz de rastrear suas aplicações CrewAI com o Langfuse para melhorar a observabilidade e a depuração.O que é Langfuse? Langfuse é uma plataforma open-source de engenharia LLM. Ela fornece recursos de rastreamento e monitoramento para aplicações LLM, ajudando desenvolvedores a depurar, analisar e otimizar seus sistemas de IA. O Langfuse se integra com várias ferramentas e frameworks através de integrações nativas, OpenTelemetry e APIs/SDKs.

Primeiros Passos

Vamos passar por um exemplo simples usando CrewAI e integrando ao Langfuse via OpenTelemetry utilizando o OpenLit.Passo 1: Instale as Dependências

Passo 2: Configure as Variáveis de Ambiente

Defina suas chaves de API do Langfuse e configure as opções de exportação do OpenTelemetry para enviar os traces ao Langfuse. Consulte a Documentação Langfuse OpenTelemetry para mais informações sobre o endpoint Langfuse OpenTelemetry/api/public/otel e autenticação.

Passo 3: Inicialize o OpenLit

Inicialize o SDK de instrumentação OpenTelemetry do OpenLit para começar a capturar traces do OpenTelemetry.Passo 4: Crie uma Aplicação Simples CrewAI

Vamos criar uma aplicação simples CrewAI onde múltiplos agentes colaboram para responder à pergunta de um usuário.Passo 5: Veja os Traces no Langfuse

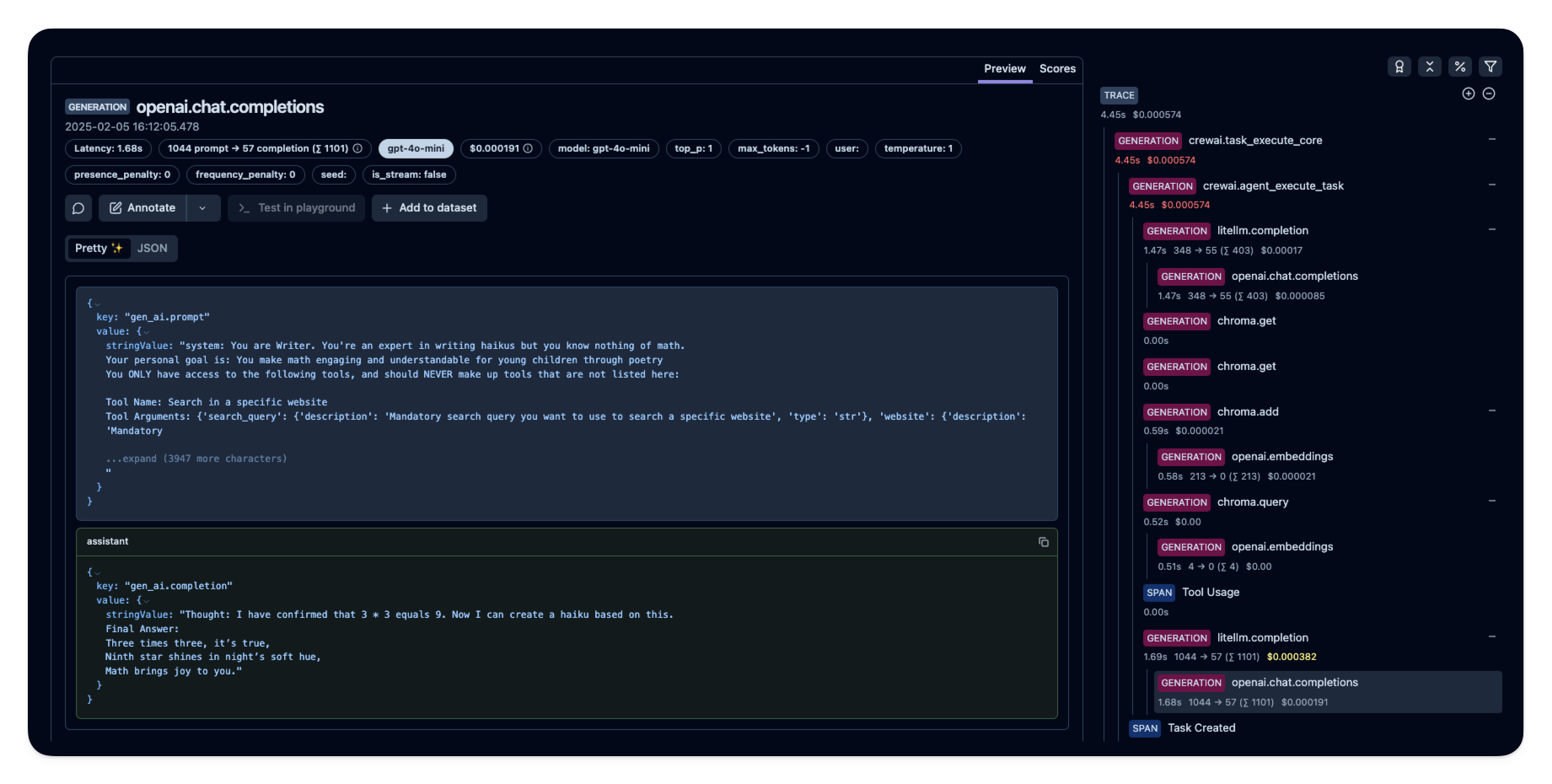

Após rodar o agente, você pode visualizar os traces gerados pela sua aplicação CrewAI no Langfuse. Você verá etapas detalhadas das interações do LLM, o que pode ajudar na depuração e otimização do seu agente de IA. Exemplo público de trace no Langfuse

Exemplo público de trace no Langfuse