Introdução

Portkey aprimora o CrewAI com recursos prontos para produção, transformando seus crews de agentes experimentais em sistemas robustos ao fornecer:- Observabilidade completa de cada etapa do agente, uso de ferramentas e interações

- Confiabilidade incorporada com fallbacks, tentativas automáticas e balanceamento de carga

- Rastreamento e otimização de custos para gerenciar seus gastos com IA

- Acesso a mais de 200 LLMs por meio de uma única integração

- Guardrails para manter o comportamento dos agentes seguro e em conformidade

- Prompts versionados para desempenho consistente dos agentes

Instalação & Configuração

Gere a Chave de API

Crie uma chave de API Portkey com limites de orçamento/taxa opcionais no painel da Portkey. Você também pode adicionar configurações para confiabilidade, cache e outros recursos a essa chave. Mais sobre isso em breve.

Configure o CrewAI com Portkey

A integração é simples – basta atualizar a configuração do LLM no seu setup do CrewAI:

O que são Virtual Keys? Virtual keys no Portkey armazenam com segurança suas chaves de API dos provedores LLM (OpenAI, Anthropic, etc.) em um cofre criptografado. Elas facilitam a rotação de chaves e o gerenciamento de orçamento. Saiba mais sobre virtual keys aqui.

Recursos para Produção

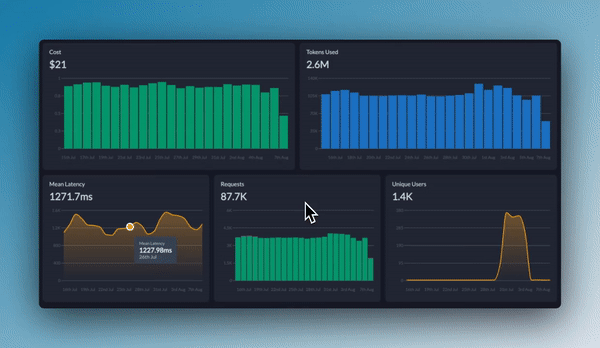

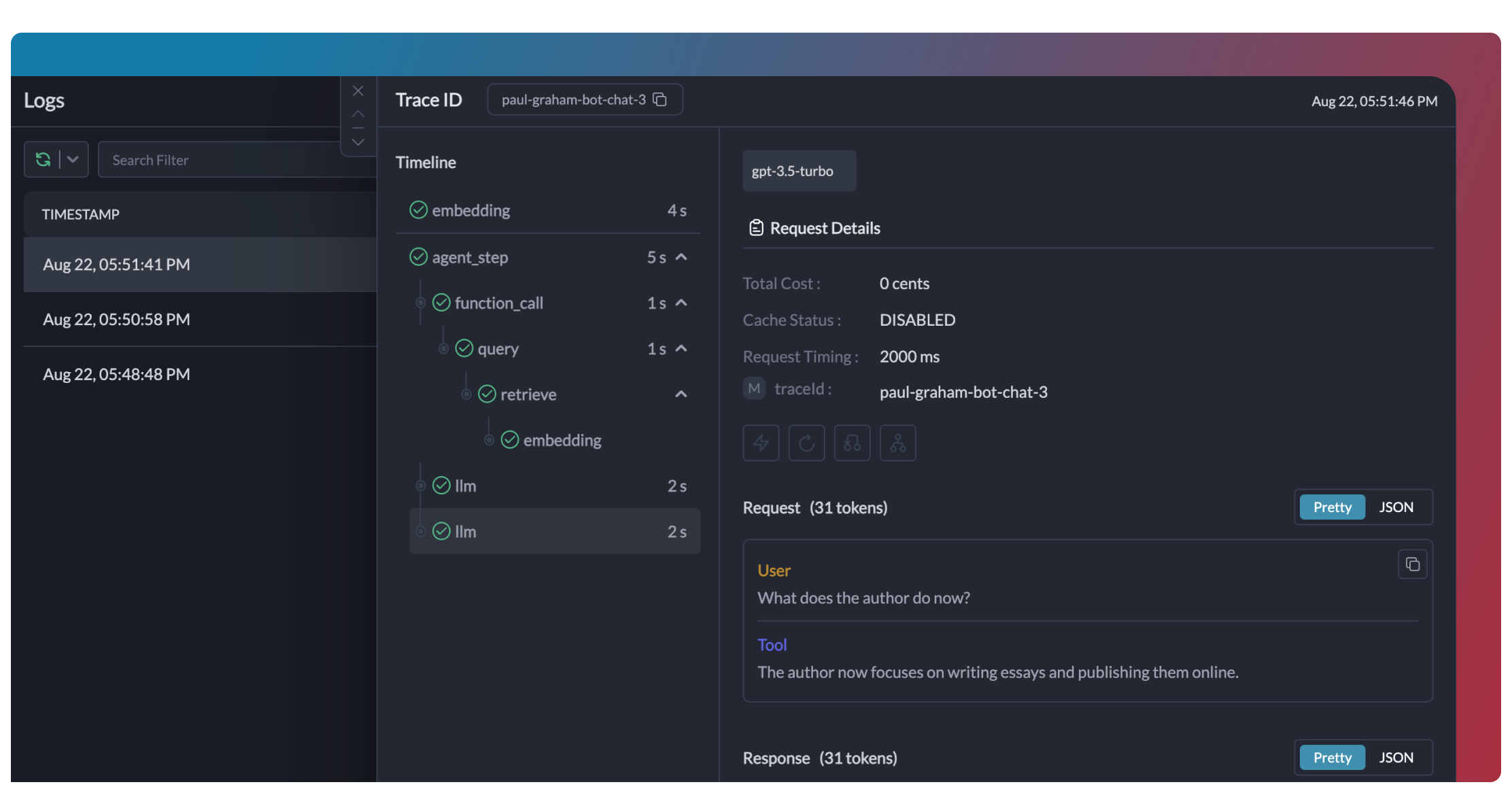

1. Observabilidade Avançada

Portkey oferece observabilidade abrangente para seus agentes CrewAI, ajudando você a entender exatamente o que está acontecendo durante cada execução.- Traces

- Logs

- Métricas & Dashboards

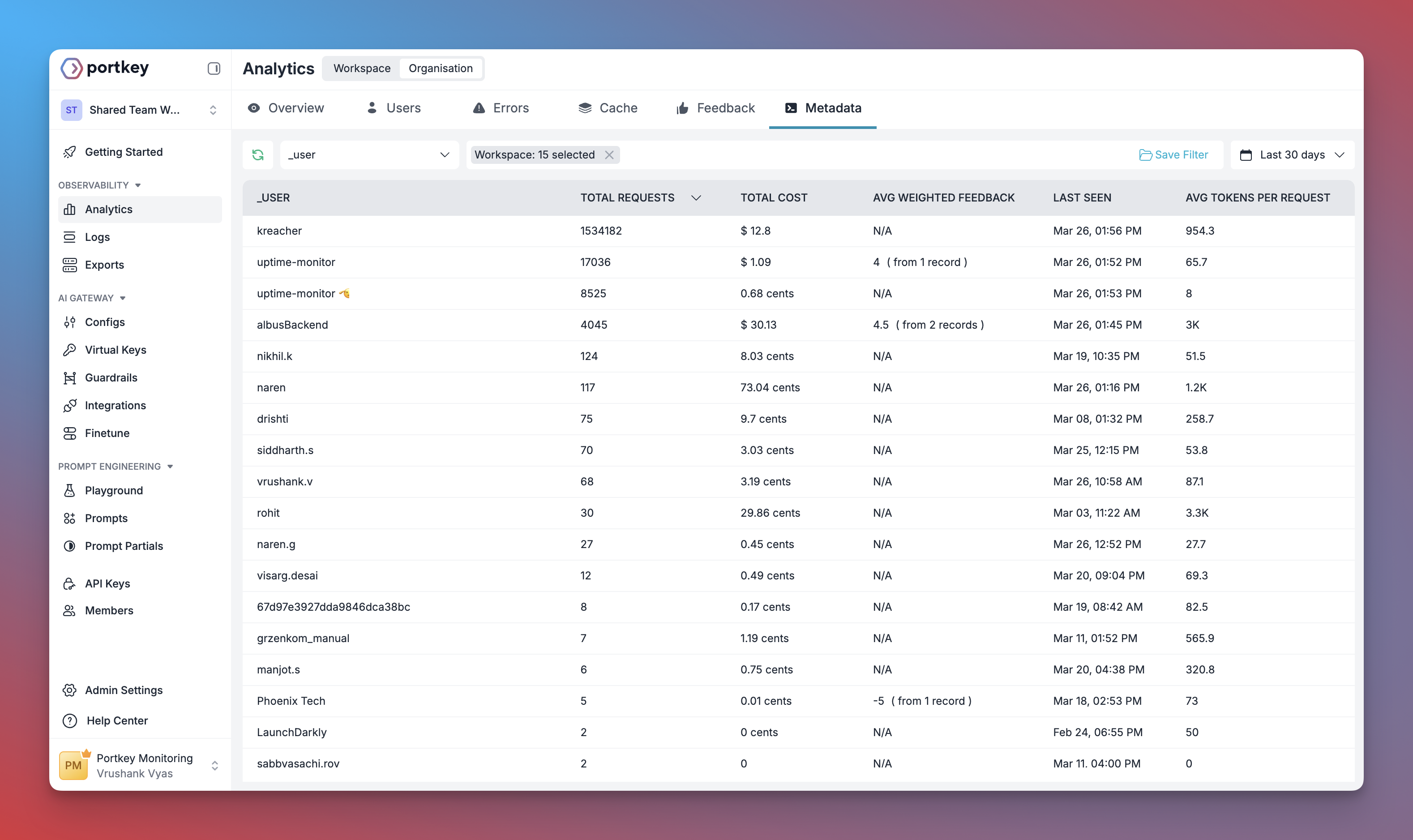

- Filtragem por Metadados

2. Confiabilidade - Mantenha Seus Crews Funcionando Sem Interrupções

Ao executar crews em produção, problemas podem ocorrer – limites de taxa da API, problemas de rede ou indisponibilidade do provedor. Os recursos de confiabilidade do Portkey garantem que seus agentes continuem funcionando mesmo quando problemas surgem. É simples habilitar fallback na sua configuração CrewAI usando um Config do Portkey:Tentativas Automáticas

Lida automaticamente com falhas temporárias. Se uma chamada LLM falhar, o Portkey fará novas tentativas o número especificado de vezes – perfeito para limites de taxa ou instabilidades de rede.

Timeouts de Requisição

Evite que seus agentes fiquem travados. Defina timeouts para garantir respostas (ou falhas controladas) dentro do tempo necessário.

Roteamento Condicional

Envie diferentes solicitações para diferentes provedores. Direcione raciocínios complexos para o GPT-4, tarefas criativas para Claude e respostas rápidas para Gemini conforme sua necessidade.

Fallbacks

Mantenha-se em funcionamento mesmo se seu provedor principal falhar. Troque automaticamente para provedores de backup para manter a disponibilidade.

Balanceamento de Carga

Distribua solicitações entre várias chaves de API ou provedores. Ótimo para operações de crew em grande escala e para permanecer dentro dos limites de taxa.

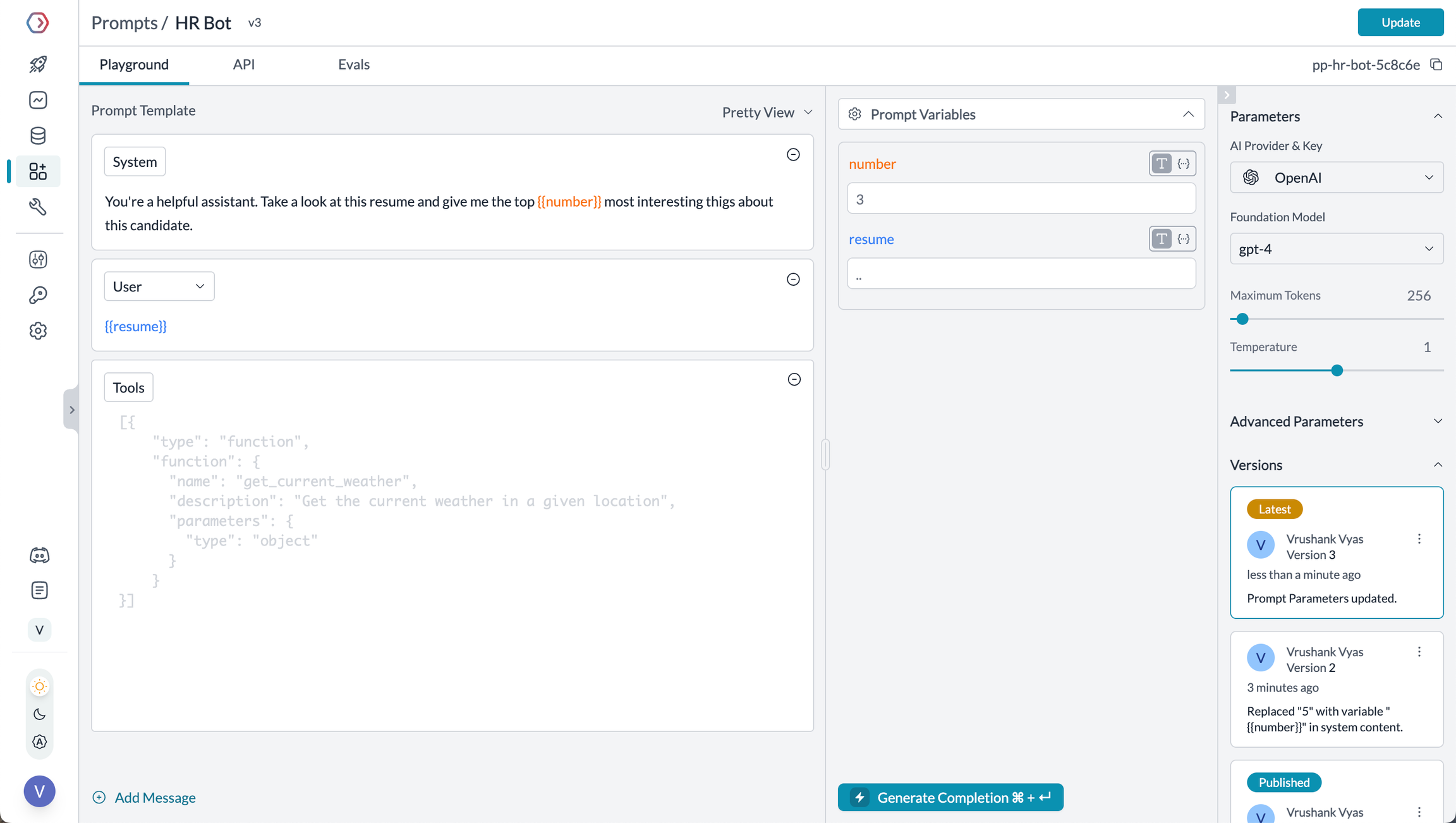

3. Prompting no CrewAI

O Prompt Engineering Studio do Portkey ajuda você a criar, gerenciar e otimizar os prompts usados em seus agentes CrewAI. Em vez de codificar prompts ou instruções manualmente, use a API de renderização de prompts do Portkey para buscar e aplicar dinâmicamente seus prompts versionados.

- Prompt Playground

- Usando Templates de Prompt

- Versionamento de Prompts

- Mustache Templating para variáveis

Prompt Playground é um local para comparar, testar e implantar prompts perfeitos para sua aplicação de IA. É onde você experimenta com diferentes modelos, testa variáveis, compara saídas e refina sua estratégia de engenharia de prompts antes de implantar em produção. Ele permite:

- Desenvolver prompts de forma iterativa antes de usá-los em seus agentes

- Testar prompts com diferentes variáveis e modelos

- Comparar saídas entre diferentes versões de prompts

- Colaborar com membros da equipe no desenvolvimento de prompts

Prompt Engineering Studio

Saiba mais sobre os recursos de gerenciamento de prompts do Portkey

4. Guardrails para Crews Seguros

Guardrails garantem que seus agentes CrewAI operem com segurança e respondam adequadamente em todas as situações. Por que usar Guardrails? Os agentes CrewAI podem apresentar falhas de diversos tipos:- Gerar conteúdo nocivo ou inapropriado

- Vazamento de informações sensíveis como PII

- Alucinar informações incorretas

- Gerar saídas em formatos incorretos

- Detectar e redigir PII tanto em entradas quanto em saídas

- Filtrar conteúdo prejudicial ou inapropriado

- Validar formatos de resposta contra schemas

- Verificar alucinações comparando com ground truth

- Aplicar lógica e regras de negócio personalizadas

Saiba Mais Sobre Guardrails

Explore os recursos de guardrails do Portkey para aumentar a segurança dos agentes

5. Rastreamento de Usuário com Metadados

Rastreie usuários individuais através dos seus agentes CrewAI utilizando o sistema de metadados do Portkey. O que é Metadata no Portkey? Metadados permitem associar dados personalizados a cada requisição, possibilitando filtragem, segmentação e analytics. O campo especial_user é projetado especificamente para rastreamento de usuário.

- Rastreamento de custos e orçamento por usuário

- Analytics personalizados por usuário

- Métricas por equipe ou organização

- Monitoramento específico por ambiente (homologação x produção)

Saiba Mais Sobre Metadata

Veja como usar metadados personalizados para aprimorar seus analytics

6. Cache para Crews Eficientes

Implemente caching para tornar seus agentes CrewAI mais eficientes e econômicos:- Caching Simples

- Cache Semântico

7. Interoperabilidade de Modelos

O CrewAI oferece suporte a múltiplos provedores de LLM, e o Portkey amplia essa capacidade fornecendo acesso a mais de 200 LLMs por meio de uma interface unificada. Você pode facilmente alternar entre diferentes modelos sem alterar a lógica central do seu agente:- OpenAI (GPT-4o, GPT-4 Turbo, etc.)

- Anthropic (Claude 3.5 Sonnet, Claude 3 Opus, etc.)

- Mistral AI (Mistral Large, Mistral Medium, etc.)

- Google Vertex AI (Gemini 1.5 Pro, etc.)

- Cohere (Command, Command-R, etc.)

- AWS Bedrock (Claude, Titan, etc.)

- Modelos locais/privados

Provedores Suportados

Veja a lista completa de provedores LLM suportados pelo Portkey

Configure Governança Corporativa para o CrewAI

Por que Governança Corporativa? Se você utiliza CrewAI dentro de sua organização, é importante considerar diversos aspectos de governança:- Gestão de Custos: Controlar e rastrear os gastos com IA entre equipes

- Controle de Acesso: Gerenciar quais equipes podem usar modelos específicos

- Analytics de Uso: Compreender como a IA está sendo utilizada na organização

- Segurança & Compliance: Manutenção de padrões corporativos de segurança

- Confiabilidade: Garantir serviço consistente para todos os usuários

Crie uma Virtual Key

Virtual Keys são a maneira segura do Portkey para gerenciar as chaves de API dos provedores de LLM. Elas fornecem controles essenciais como:

- Limites de orçamento para uso da API

- Capacidade de rate limiting

- Armazenamento seguro das chaves de API

Salve o ID da sua virtual key – você precisará dele no próximo passo.

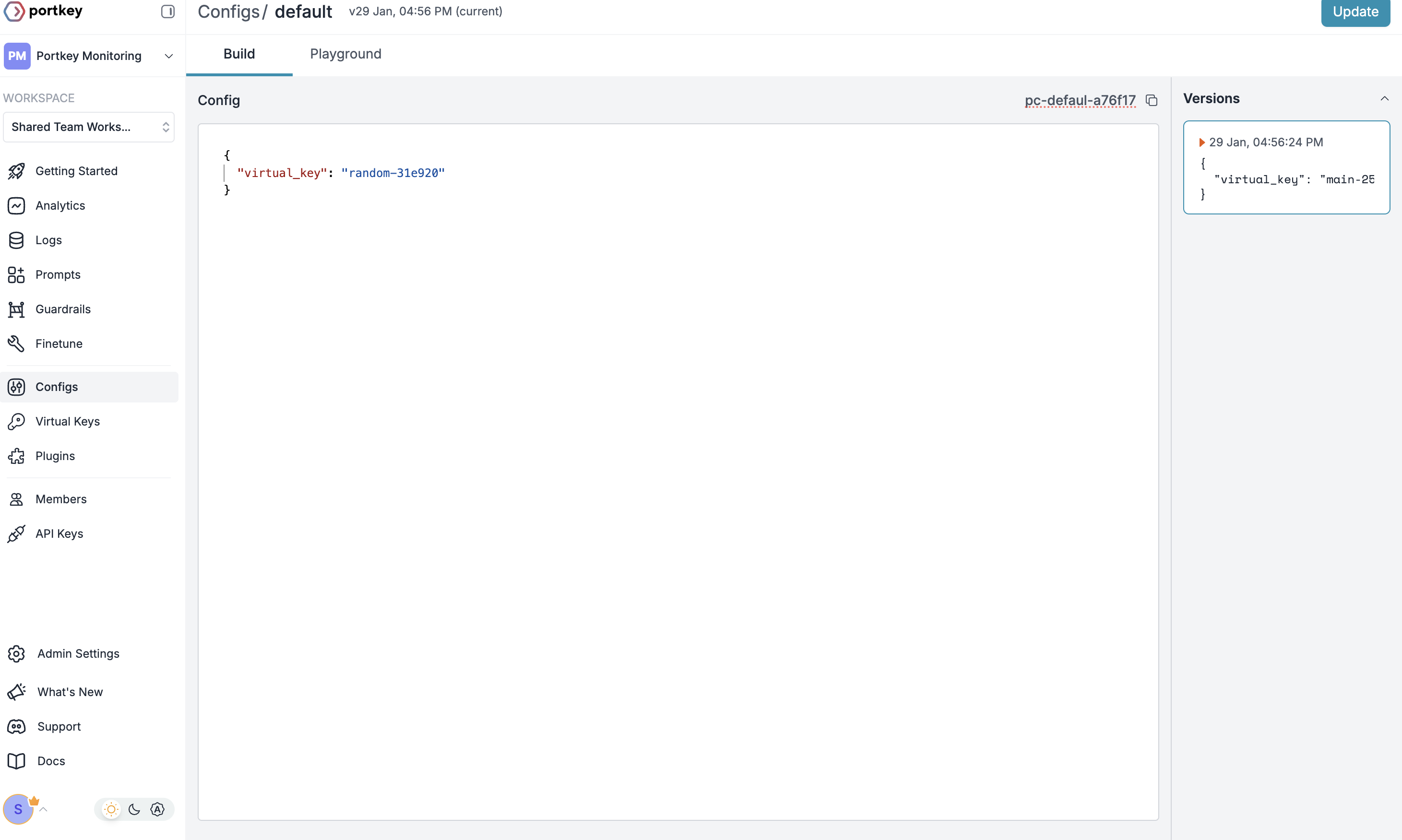

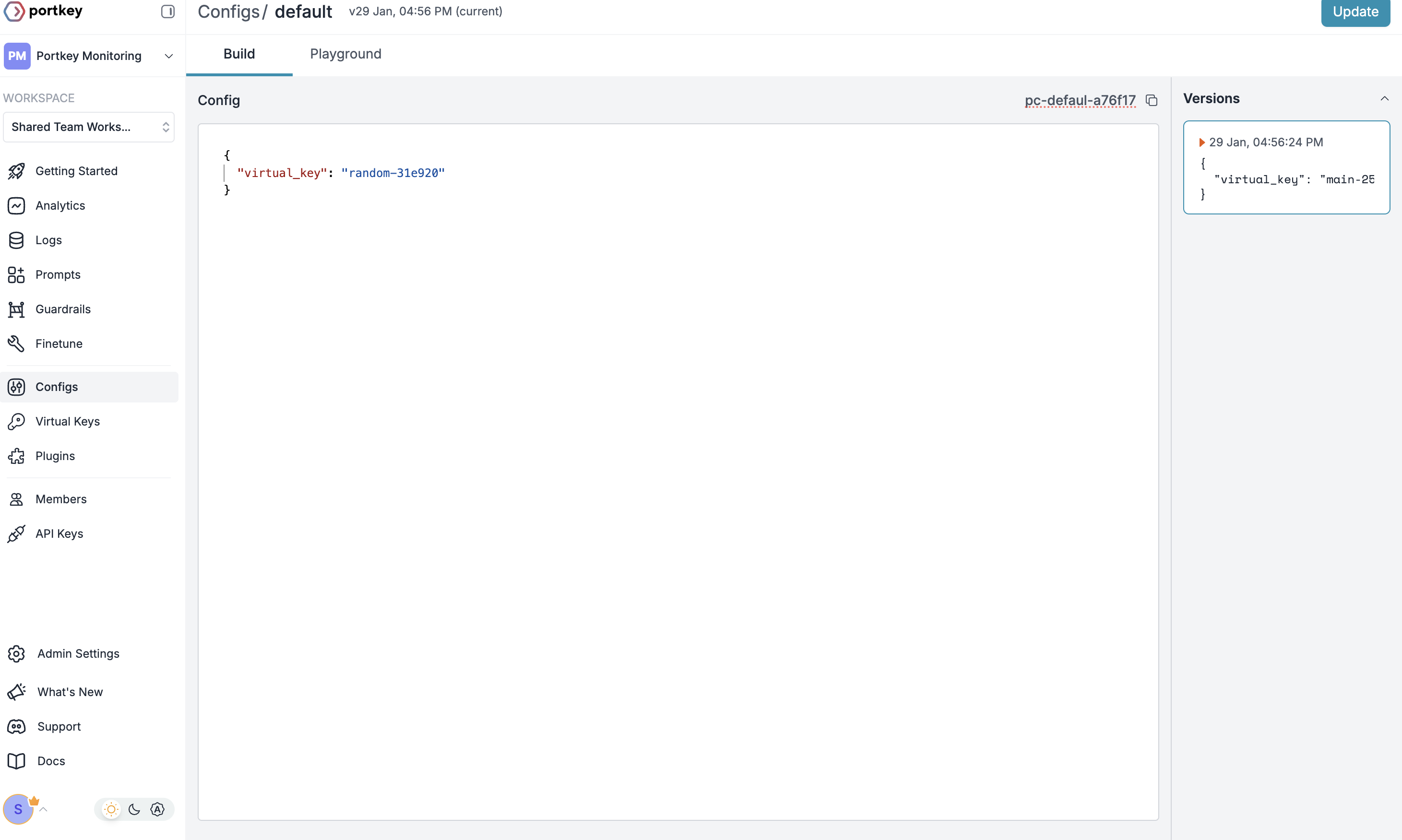

Crie um Config Padrão

Os Configs no Portkey definem como suas requisições são roteadas, com recursos como roteamento avançado, fallbacks e tentativas automáticas.Para criar seu config:

- Vá até Configs no painel Portkey

- Crie um novo config com:

- Salve e anote o nome do Config para o próximo passo

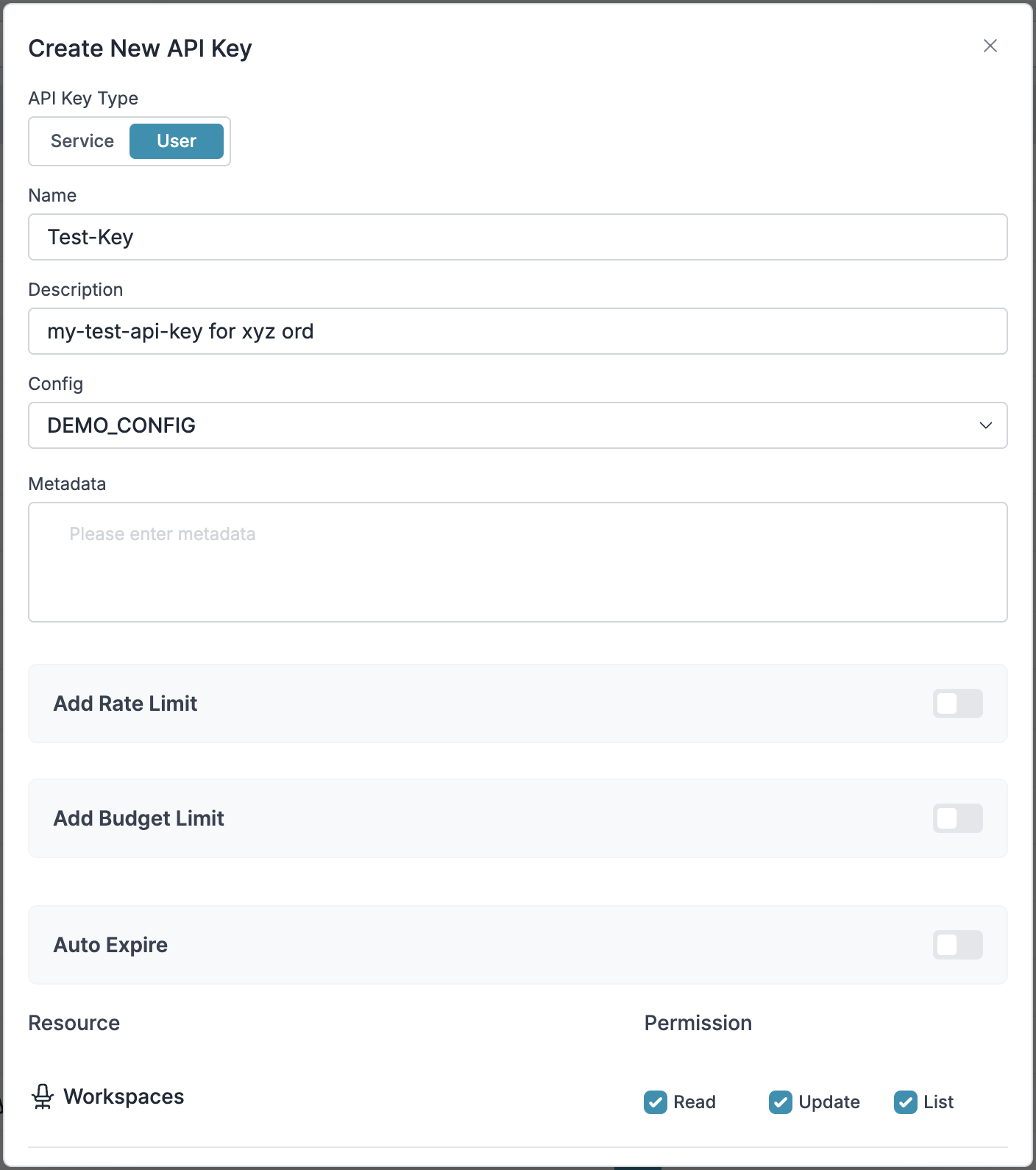

Configure a Chave de API Portkey

Agora crie uma chave de API Portkey e anexe a config criada no Passo 2:

- Vá até API Keys na Portkey e crie uma nova chave de API

- Selecione sua config do

Passo 2 - Gere e salve sua chave de API

Etapa 1: Implementar Controles de Orçamento & Rate Limits

Etapa 1: Implementar Controles de Orçamento & Rate Limits

Etapa 1: Implementar Controles de Orçamento & Rate Limits

Virtual Keys permitem controle granular sobre o acesso ao LLM por equipe/departamento. Isso ajuda você a:- Definir limites de orçamento

- Prevenir picos inesperados de uso através de Rate limits

- Rastrear gastos por departamento

Configurando controles específicos de departamento:

- Vá até Virtual Keys no painel Portkey

- Crie uma nova Virtual Key para cada departamento com limites de orçamento e rate limits

- Configure limites específicos por departamento

Etapa 2: Definir Regras de Acesso a Modelos

Etapa 2: Definir Regras de Acesso a Modelos

Etapa 2: Definir Regras de Acesso a Modelos

À medida que o uso de IA cresce, controlar quais equipes têm acesso a quais modelos se torna fundamental. Os Configs do Portkey fornecem essa camada de controle com recursos como:Recursos de Controle de Acesso:

- Restrições de Modelo: Limite o acesso a modelos específicos

- Proteção de Dados: Implemente guardrails para dados sensíveis

- Controles de Confiabilidade: Adicione fallbacks e tentativas automáticas

Exemplo de Configuração:

Aqui está um exemplo básico para rotear requisições ao OpenAI, usando especificamente o GPT-4o:Os configs podem ser atualizados a qualquer momento para ajustar controles sem afetar aplicações em execução.

Etapa 3: Implementar Controles de Acesso

Etapa 3: Implementar Controles de Acesso

Etapa 3: Implementar Controles de Acesso

Crie chaves de API específicas por usuário que automaticamente:- Rastreiam uso por usuário/equipe com o auxílio das virtual keys

- Aplicam configs adequadas para rotear requisições

- Coletam metadados relevantes para filtragem de logs

- Impõem permissões de acesso

Etapa 4: Implante & Monitore

Etapa 4: Implante & Monitore

Etapa 4: Implante & Monitore

Após distribuir as chaves de API para os membros da equipe, seu setup corporativo CrewAI está pronto. Cada membro pode agora usar suas chaves designadas com os níveis de acesso e controles de orçamento apropriados.Monitore o uso no painel Portkey:- Rastreamento de custos por departamento

- Padrões de uso de modelos

- Volume de requisições

- Taxa de erros

Recursos Corporativos Agora Disponíveis

Sua integração CrewAI agora conta com:- Controles de orçamento departamental

- Governança de acesso a modelos

- Rastreamento de uso & atribuição

- Guardrails de segurança

- Recursos de confiabilidade

Perguntas Frequentes

Como o Portkey aprimora o CrewAI?

Como o Portkey aprimora o CrewAI?

Portkey adiciona prontidão para produção ao CrewAI através de observabilidade abrangente (traces, logs, métricas), recursos de confiabilidade (fallbacks, tentativas automáticas, cache) e acesso a mais de 200 LLMs por meio de uma interface unificada. Isso facilita depurar, otimizar e escalar suas aplicações de agentes.

Posso usar Portkey com aplicações CrewAI existentes?

Posso usar Portkey com aplicações CrewAI existentes?

Sim! Portkey integra-se perfeitamente a aplicações CrewAI existentes. Basta atualizar o código de configuração do LLM com a versão habilitada do Portkey. O restante do seu código de agente e crew permanece inalterado.

Portkey funciona com todos os recursos do CrewAI?

Portkey funciona com todos os recursos do CrewAI?

Portkey suporta todos os recursos do CrewAI, incluindo agentes, ferramentas, workflows human-in-the-loop e todos os tipos de processo de tarefas (sequencial, hierárquico, etc.). Ele adiciona observabilidade e confiabilidade sem limitar nenhuma funcionalidade do framework.

Posso rastrear o uso em múltiplos agentes de um crew?

Posso rastrear o uso em múltiplos agentes de um crew?

Sim, o Portkey permite que você use um

trace_id consistente em múltiplos agentes de um crew para rastrear todo o fluxo de trabalho. Isso é especialmente útil para crews complexos onde você deseja entender o caminho completo de execução entre os agentes.Como filtro logs e traces para execuções específicas de crew?

Como filtro logs e traces para execuções específicas de crew?

O Portkey permite adicionar metadados personalizados à configuração do seu LLM, que podem ser usados para filtragem. Adicione campos como

crew_name, crew_type, ou session_id para encontrar e analisar facilmente execuções específicas do crew.Posso usar minhas próprias chaves de API com o Portkey?

Posso usar minhas próprias chaves de API com o Portkey?

Sim! O Portkey utiliza suas próprias chaves de API dos provedores LLM. Elas são armazenadas com segurança como virtual keys, permitindo que você gerencie e gire as chaves facilmente sem alterar seu código.